本教程将指导您如何在 Windows 系统上安装和配置 Ollama 和 Deepseek 工具。

1.安装 Ollama

1.1 下载 Ollama

访问 Ollama 的官方网站或 GitHub 仓库又或者百度云盘下载,下载适用于 Windows 的安装包。

Ollama官网:https://ollama.com/

GitHub仓库:https://github.com/ollama/ollama

百度云盘: https://pan.baidu.com/s/1UBdNh9AQPKtIMQBmLXBWmw?pwd=k6dp

1.2 安装 Ollama

1. 在线安装

curl -fsSL https://ollama.com/install.sh | sh2.离线安装

#1.下载文件放到Ollama文件相同目录下:

wget https://ollama.com/install.sh

#2.install.sh修改:注释掉下面4行代码 ,末尾添加

#status "Downloading Linux ${ARCH} bundle"

#curl --fail --show-error --location --progress-bar \

#"https://ollama.com/download/ollama-linux-${ARCH}.tgz${VER_PARAM}" | \

#$SUDO tar -xzf - -C "$OLLAMA_INSTALL_DIR"

#3.添加的代码:

$SUDO tar -C "$OLLAMA_INSTALL_DIR" -xzf ./ollama-linux-amd64.tgz

#4.安装

sudo chmod a+x install.sh

./install.sh1.3 验证安装

1. 输入以下命令验证 Ollama 是否安装成功:

ollama --version 如果显示版本号,说明安装成功。

2. 安装 Deepseek

2.1 下载 Deepseek

Ollama命令行安装或百度网盘下载适用于系统大小的模型。

模型大小选择

命令行执行

百度网盘下载

百度网盘:https://pan.baidu.com/s/1FCU6RMOfFRDLudCnBRIyUA?pwd=q6de

以Deepseek7B为例:下载完成后CMD到Deepseek7B目录内执行命令

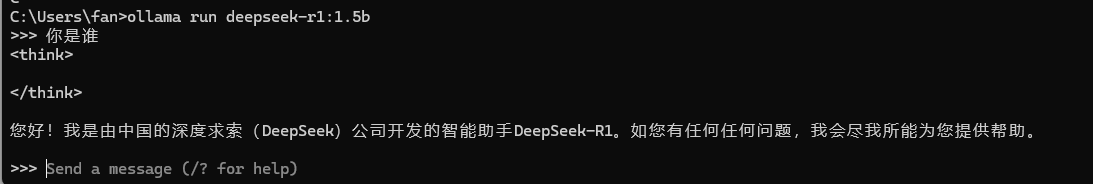

ollama create deepseek-r1_7b -f DeepSeek-R1-Distill-Qwen-7B-Q4_K_M.modelfile2.1 验证安装

3. 配置 Ollama

3.1 远程部署

假如我们在远程的电脑上部署了一个ollama+deepseek,想在本地电脑用chatbox调用远程ollama的API,这个也是支持的,但是要在远程电脑上进行相应的配置。

#先暂停ollama服务:

sudo systemctl stop ollama

#修改配置文件:

sudo vi /etc/systemd/system/ollama.service

#在配置文件的[Service]下加上这么两句:

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

#重新加载ollama服务

systemctl daemon-reload

$ systemctl restart ollama4.安装交互UI

Chatbox(安装教程)

Page Assist(安装教程)

Cherry Studio(安装教程)

OpenWebUI(安装教程)

Dify(安装教程待更新)

Ragflow(安装教程待更新)

FastGPT(安装教程待更新)

OneAPI(安装教程待更新)

5. 常见问题

5.1 安装失败

如果安装过程中遇到问题,请确保您的系统满足最低要求,并尝试以管理员身份运行安装程序。

5.2 联系作者

作者提供远程安装服务,一对一服务,店铺:数智互联

通过以上步骤,您应该已经成功在 Windows 系统上安装并配置了 Ollama 和 Deepseek。如果您有任何问题,请参考官方文档或社区支持。